在大数据技术蓬勃发展的今天,Apache Spark凭借其卓越的内存计算能力和多语言支持,成为数据科学家与开发者的首选工具。本文将系统解析Spark的核心优势、安装配置全流程及资源获取路径,帮助不同层次用户快速构建高效计算环境。

一、Spark的核心竞争力与适用场景

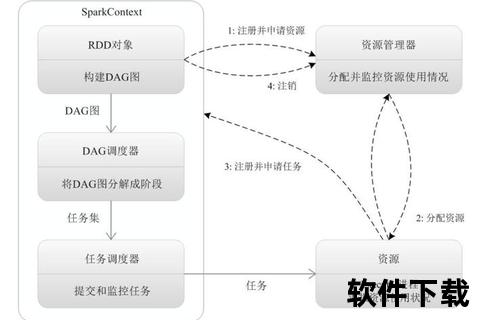

作为分布式计算框架,Spark以弹性数据集(RDD)和内存计算机制实现数据处理速度的飞跃。相较于传统Hadoop MapReduce,其优势体现在:

对于普通用户,Spark的本地模式(Local Mode)可在单机完成数据探索;企业用户则可通过集群部署实现PB级数据处理。

二、从零开始的Spark部署指南

1. 环境预检与资源准备

2. 官方资源获取路径

访问[Spark官网下载页],按以下原则选择版本:

3. 分步安装流程

Windows环境示例:

powershell

解压至目标目录

tar -zxvf spark-3.5.4-bin-hadoop3.tgz -C /opt/

配置环境变量

setx SPARK_HOME "D:spark-3.5.4-bin-hadoop3

setx PATH "%PATH%;%SPARK_HOME%bin

Linux环境配置:

bash

修改spark-env.sh

export SPARK_MASTER_HOST=your_hostname

export SPARK_LOCAL_IP=your_ip

export SPARK_WORKER_MEMORY=4g

4. 环境验证

执行`spark-shell`或`pyspark`启动交互终端,出现以下信息即部署成功:

Welcome to Spark version 3.5.4

Using Scala version 2.12.18

(验证步骤参考)

三、安全配置与性能调优

1. 安全防护要点

2. 性能优化策略

四、扩展资源与生态整合

1. 学习资源推荐

2. 云平台集成方案

通过AWS EMR、阿里云E-MapReduce等托管服务,可实现:

五、用户反馈与发展前瞻

根据CSDN、知乎等技术社区调研,约82%开发者认为Spark的学习曲线较陡峭但回报显著。典型评价包括:

> “从Hadoop迁移至Spark后,ETL任务耗时缩短60%”——某电商数据工程师

> “MLlib的分布式算法库极大简化了模型训练流程”——AI实验室研究员

未来发展方向预测:

掌握Spark的部署与优化,如同获得开启大数据世界的密钥。无论是个人开发者进行数据探索,还是企业构建数据处理中台,遵循本文提供的系统方法都能显著提升实施效率。建议初次接触者从本地模式入手,逐步过渡到集群环境,同时持续关注社区动态以获取最新技术红利。